145 Seiten über künstliche Intelligenz – und am Ende doch vor allem die Frage: Was macht uns als Menschen aus?

Lukas Brand (@lukbrand 🐦): Künstliche Tugend: Roboter als moralische Akteure. Verlag Friedrich Pustet, Regensburg 2018.

«Wer bezahlt, wenn Alexa bestellt?»

Die Frage steht über dem Klappentext des Buches und fasst das Thema perfekt zusammen: Der katholische Theologe Lukas Brand fragt in «Künstliche Tugend» nach Verantwortung und Ethik von Maschinen.

- Sind Roboter moralische Akteure? Ist es möglich, Maschinen mit künstlicher Intelligenz (KI) herzustellen, die selbständig moralische Urteile fällen?

- Welches Ethikkonzept würde sich als Basis für diese künstlichen moralischen Akteure eignen?

- Wer steht dafür gerade, wenn ein Urteil sich im Nachhinein als falsch herausstellt?

Im Folgenden fasse ich den roten Faden des Buches knapp zusammen. Ich empfehle, «Künstliche Tugend» aber unbedingt selber zu lesen:

Es bietet neben der spannenden ethischen Fragestellung einen tollen, kompakten Einblick in die Entwicklung von KI und deren Stand heute, inklusive Chancen und Gefahren.

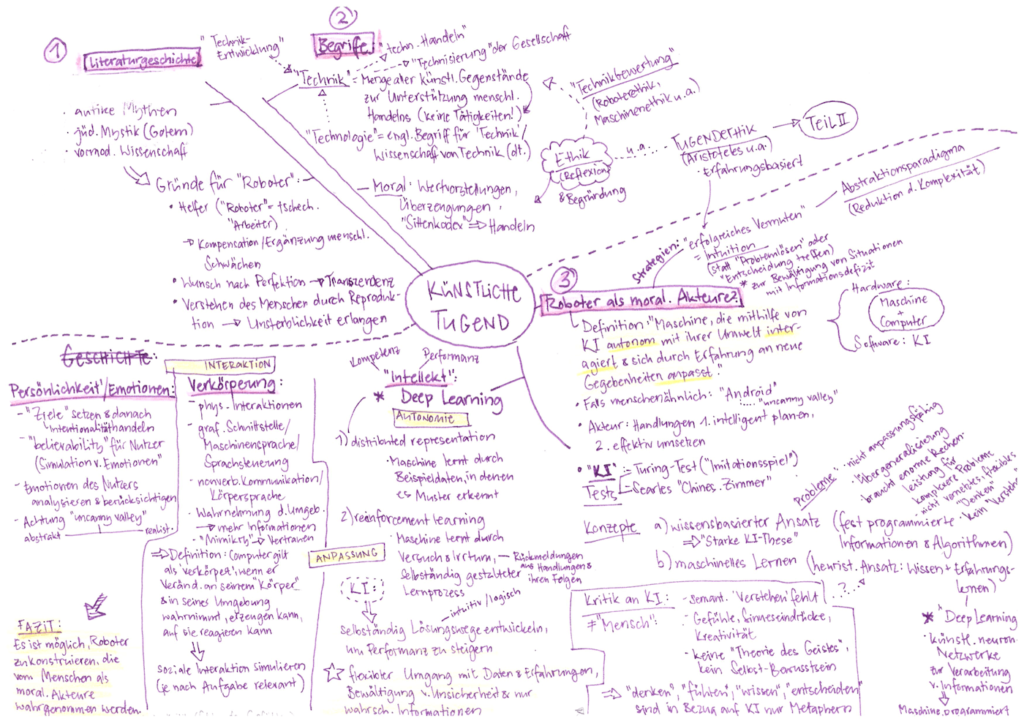

Lehrreich: Begriffe und Geschichte der KI

Wovon reden wir eigentlich, wenn wir «Maschine», «Technik» oder «Moral» sagen? In der ersten Hälfte des Buches nimmt Brand eine Definition und Abgrenzung von einigen Kernbegriffen vor; u.a.:

- Roboter: «Ein Roboter ist eine beliebige Maschine, die mithilfe künstlicher Intelligenz autonom mit ihrer Umwelt interagiert und sich durch Erfahrung an neue Gegebenheiten anpasst.»

- Akteur: besitzt die «Fähigkeit, Handlungen intelligent zu planen, andererseits das Vermögen, diese Handlungen effektiv in die Tat umzusetzen.»

- Verschiedene Bereiche der Technikbewertung: Roboterethik, Technikethik, Ingenieursethik und Maschinenethik.

- Letztere ist Kernthema des Buches und wird nach Anderson/Anderson folgendermassen definiert: «Die Maschinenethik ist ‹daran interessiert, Maschinen ethische Prinzipien oder ein Verfahren zu geben, mit denen sie Lösungswege für die ethischen Dilemmata finden, denen sie begegnen könnten'». So ermöglicht Maschinenethik künstlichen Akteuren, «‹durch ihre eigenen ethischen Entscheidungen ethisch verantwortlich zu handeln›.»

Der Turing-Test als Kriterium

1950 entwickelte Alan Turing einen Test, um festzustellen, ob eine Maschine einem Menschen intellektuell gleichwertig ist. Kurzbeschreibung von Wikipedia:

«Im Zuge dieses Tests führt ein menschlicher Fragesteller über eine Tastatur und einen Bildschirm ohne Sicht- und Hörkontakt mit zwei ihm unbekannten Gesprächspartnern eine Unterhaltung. Der eine Gesprächspartner ist ein Mensch, der andere eine Maschine. Wenn der Fragesteller nach der intensiven Befragung nicht klar sagen kann, welcher von beiden die Maschine ist, hat die Maschine den Turing-Test bestanden, und es wird der Maschine ein dem Menschen ebenbürtiges Denkvermögen unterstellt.»

Brand hält einen analogen «moralischen Turing-Test» für ein geeignetes Tool, um zu beurteilen, ob ein Roboter moralisch genauso gute oder bessere Entscheidungen trifft wie ein Mensch.

Doch wie kann ein Roboter (zumindest theoretisch) die Fähigkeit erlangen, überhaupt ethische Entscheidungen zu treffen?

Um die Voraussetzungen und Grundlagen zu klären, zeichnet der Autor in der ersten Hälfte seines Buches die Geschichte der Künstlichen Intelligenz nach.

KI: Kein neues Thema!

Lukas Brand beginnt in der Literaturgeschichte, bei antiken Mythen wie Hephaistos, dem Golem in der jüdischen Mystik, Frankensteins Monster etc.

Es wird deutlich, dass wir KI und Roboter zwar als modernes Phänomen wahrnehmen, dass der Gedanke dahinter jedoch Jahrtausende zurück reicht.

Schon sehr lange träumt der Mensch bereits davon, seine eigenen Schwächen mit künstlichen Helfern zu kompensieren oder einen perfekten Menschen zu erschaffen und so Transzendenz zu erreichen. Zumindest in der Literatur ist die Faszination stets mit einem leisen Schaudern verbunden, und die meisten der Erzählungen enden in einem Drama.

In der Realität ist dies zum Glück nicht die Regel. Brand beschreibt geschichtliche Brennpunkte in der Entwicklung und Erforschung der KI bis heute und vermittelt das Grundwissen zur Funktionsweise von künstlicher Intelligenz. Ich fand diesen Teil mit den vielen Beispielen und Konzepten sehr spannend und lehrreich.

So wird z.B. der grundlegende Unterschied zwischen einem wissensbasierten Ansatz und dem maschinellen Lernen erklärt:

Wissensbasierter Ansatz vs. Machine Learning

Beim wissensbasierten Ansatz werden Informationen und Algorithmen fest programmiert («top-down»). Jeder Befehl löst eine Aktion aus, A > B.

Je grösser die Rechenleistung, desto komplexere Probleme kann die KI bewältigen.

Beim Machine Learning werden hingegen nur Grundalgorithmen und Zielvorgaben programmiert. Die Maschine nutzt dann künstliche neuronale Netzwerke zur Verarbeitung von Informationen aus «Erfahrungen», um die Leistung zu steigern. Sie programmiert sich im Prinzip selbst («bottom-up»).

Beispiel: Ein Übersetzungsprogramm erhält als Grundlage 1:1-Bausteine (das Haus = la maison; «Ich liebe XY» = «j’aime XY»). Ein anderes Übersetzungsprogramm erhält zusätzlich Datensätze mit Beispieltexten der jeweiligen Sprachen und verarbeitete diese mittels künstlichen neuronalen Netzwerken. Es «denkt vernetzt», erkennt den Kontext eines Textes, kann sich an die unterschiedlichen sprachlichen Strukturen anpassen und liefert dadurch viel präzisere Übersetzungen. (Artikel dazu: «DeepL vs. Google Translate«, SZ 25.1.2019)

Folgerung: Um die Bedingungen von Autonomie, Interaktion und Anpassungsfähigkeit (siehe oben, Definition eines Roboters) zu erfüllen, muss eine KI mittels maschinellem Lernen funktionieren. Nur so kann die KI flexibel mit Daten und Erfahrungen umgehen und auch neue, nicht programmierte Situationen und Unsicherheit bewältigen – in Bezug auf Ethik zentral!

Verkörperung und Persönlichkeit

Neben dem «Intellekt», der für ethische Entscheidungen notwendig ist, werden auch die Themen «Verkörperung» und» Persönlichkeit» behandelt.

«Verkörperung» ist in Bezug auf die Wahrnehmung und Interaktion mit der Umgebung wichtig. Die Verkörperung reicht dabei von einer grafischen Schnittstelle über Sprachsteuerung bis zu Mimikry von Körpersprache bei einem Androiden.

Mit einem physischen Körper (wie auch immer der aussehen mag) erhält die Maschine einerseits massiv mehr Daten über die Umgebung. So kann sie u.a. Konsequenzen ihrer Handlungen erkennen, auswerten und darauf reagieren.

Andererseits wird die KI mit einem Körper vom Menschen auch eher als Akteur wahrgenommen. Die Interaktion wird komplexer – und emotionaler.

Dazu auch die Frage nach dem «Charakter» eines Roboters:

Robotern eine «Persönlichkeit» zu geben, steigert zwar die «believability» für Nutzer, ist aber für die Funktion einer Maschine an und für sich irrelevant. In Bezug auf ethisch relevante Situationen ist eine «Persönlichkeit» sogar störend: Eine Maschine soll solche Situationen möglichst neutral und objektiv analysieren können und entscheiden.

Fazit 1:

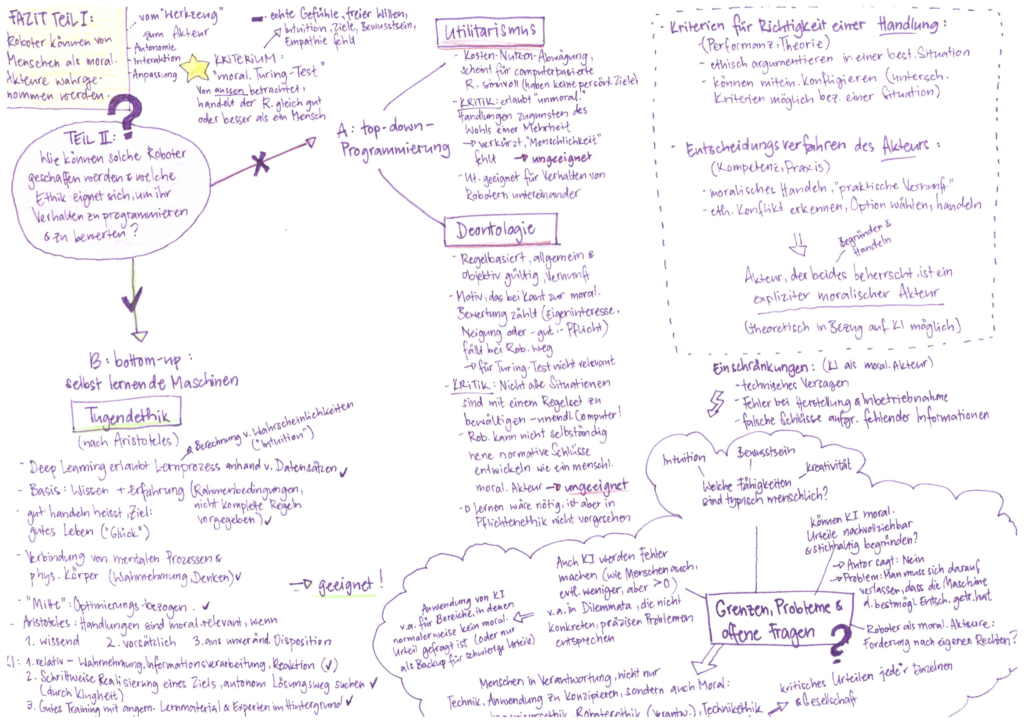

Der erste Teil des Buches sollte die Frage klären, ob eine Maschine vom Menschen als moralischer Akteur wahrgenommen werden kann. Geschichte und Entwicklungsstand der KI zeigen: Grundsätzlich ist das möglich.

Welches Ethik-Konzept für moralische Maschinen?

Im zweiten Teil von «Künstliche Tugend» untersucht Brand den Utilitarismus, die kantianische Pflichtenethik und die aristotelische Tugendethik. Welches der drei Konzepte sich seiner Ansicht nach am besten eignet, um Robotern moralisches Verhalten beizubringen, verrät schon der Titel seines Buches.

Ethikkonzepte stellen Kriterien für die Richtigkeit einer Tat (Fokus auf die Handlung) zur Verfügung, lassen aber auch Entscheidungsverfahren (Fokus auf den Akteur) begründen.

1. Utilitarismus

Der Utilitarismus scheint als Kosten-Nutzen-Abwägung zwar vordergründig eine gute Wahl für computerbasierte Maschinen. Jedoch werden nach diesem Konzept, radikal angewendet, Situationen zu stark abstrahiert:

Es sind Entscheidungen möglich und sogar wahrscheinlich, welche unmoralische Handlungen bezüglich einer Minderheit erfordern, zugunsten des Wohls der Mehrheit. Menschliche Akteure erkennen dieses Dilemma und lassen in solchen Situationen auch andere Ethikkonzepte (z.B. das deontologische Tötungsverbot) in die Beurteilung einfliessen.

2. Deontologische Ethik

Die Pflichtenethik hat starke Parallelen zum wissensbasierten Ansatz, der oben kurz erklärt wurde: Ethische Entscheidungen werden nach fixen, allgemein gültigen Regeln getroffen (z.B. Verbot zu lügen).

Nach Immanuel Kant ist dabei zentral, ob der moralische Akteur aus Neigung, Eigeninteresse oder Pflicht handelt. Nur wenn aus reiner Pflicht korrekt gehandelt wird, ist die Tat moralisch als gut zu beurteilen.

Da eine Maschine über kein Bewusstsein verfügt und keine Neigungen im menschlichen Sinne besitzt, sind die Motive ihrer Taten ethisch irrelevant.

Dennoch hält Brand auch die regelbasierte Ethik für ungeeignet, um Robotern Moral einzuprogrammieren: Sie ist zu starr, nicht alle Situationen lassen sich mit einem vorgegebenen Regelset bewältigen.

3. Tugendethik

«Tugend» als Konzept für eine moralisch gute Haltung wurde zuerst von Aristoteles entwickelt. Er war auf der Suche nach einem Rezept für ein glückliches Leben und fand dieses in tugendhaftem Handeln.

In neuerer Zeit wurde Tugendethik von der Philosophie und der Ethik wiederentdeckt.

Wie die Pflichtenethik Ähnlichkeiten mit dem wissensbasierten Ansatz aufwies, zeigt die aristotelischeTugendethik Parallelen zum Machine Learning.

- Tugend basiert auf a) einer bestimmten Disposition, b) angeeignetem Wissen und c) auf Erfahrung – nicht alle Faktoren werden vorprogrammiert

- Wahrnehmung und Denken werden verknüpft

- Wahrscheinlichkeit, Intuition ist zulässig für Entscheidungen

- Vorbilder sind wichtig als Orientierungshilfe (wie würde ein [tugendhafter] Mensch in dieser Situation handeln?)

- Lernprozesse (welche in Bezug auf Maschinen durch künstliche neuronale Netzwerke ermöglicht werden) spielen in der Tugendethik eine wichtige Rolle

Brand entwirft ein Konzept dafür, welches Lernmaterial sich eignen würde, damit eine KI Moral im Sinne von Tugend erlernt. Wichtig sind v.a. eine grosse Anzahl und Vielfalt an Beispieldaten. Expert*innen würden den Lernprozess überwachen und erwünschtes Verhalten bestärken, unerwünschtes unterbinden.

Fazit 2:

Eine solche Basis für moralische Roboter bedingt einen Lernraum und schliesst nicht aus, dass Fehlentscheide passieren – wie auch bei Menschen. Zudem sind Entscheide, welche Intuition und Erfahrung als Faktoren einbeziehen, nicht immer stichhaltig begründ- und nachvollziehbar.

Dennoch hält Brand die Tugendethik als Ethikkonzept für künstliche moralische Akteure für am geeignetsten.

Wer bezahlt denn aber nun, wenn Alexa bestellt?

Es gibt darauf keine einfache Antwort. Eine grosse Stärke im Buch von Lukas Brand liegt darin, dass der Autor KI sachlich und weitgehend unemotional betrachtet. Weder die Gefahren noch die Chancen nehmen klar überhand, sondern werden anhand von Beispielen differenziert betrachtet und entlang von Grundsatzfragen abgewogen.

Die Verantwortung für Entscheidungen von KI teilt sich auf in Ingenieursethik (Herstellung, Programmierung), Roboterethik (werden Roboter mit Fehlerpotenzial überhaupt zugelassen?) und Technikethik (Anwenderkompetenz).

Jede*r Einzelne muss kritisch beurteilen, wie sie Maschinen mit KI in ihrem Alltag einsetzt. Und die Gesellschaft als Ganze muss sich bewusstmachen, was das bedeutet und wo Regeln zu entwerfen und Grenzen zu ziehen sind.

Chancen und Gefahren

Die Frage nach moralischen Regeln für KI stellt sich heute schon brennend. Ein Mindestmass an ethischer Reflexion ist in vielen Anwendungsbereichen deswegen unverzichtbar und muss parallel zur technischen Entwicklung laufen.

KI jedoch mit selbständigen ethischen Kompetenzen auszustatten, empfiehlt Lukas Brand jedoch nur ganz gezielt. Und zwar dort, wo moralische Entscheidungen nicht an der Tagesordnung sind, sondern die Maschinen ansonsten konkrete, vorgegebene Tätigkeiten übernehmen.

Oder aber als «Backup» für moralische Entscheidungen, welche in Situationen nötig werden, welche einen einzelnen Menschen überfordern. Darunter verstehe ich beispielsweise ein selbstfahrendes Auto, bei dem sich sehr plötzlich ein Unfall anbahnt und eine Entscheidung so schnell getroffen werden muss, dass dies menschlich unmöglich wäre.

Hierin liegen die grossen Chancen in der Anwendung von «moralischen Maschinen».

Brand bringt jedoch auch immer wieder Beispiele, die klar aufzeigen, wo die Gefahren liegen: Wenn zum Beispiel im medizinischen Kontext ethische Entscheidungen von KI vorgetroffen, dann aber wegen hoher Belastung nicht mehr sorgfältig von Menschen geprüft werden.

KI als Thema für die Schöpfungslehre

Wenn Roboter moralische Akteure werden, wird sich irgendwann auch die Frage nach eigenen Rechten stellen für sie als Partizipierende an der Gesellschaft. Hier tut sich ethisch noch ein ganz neues Fass auf, bei welchem Brand nur über den Rand äugt.

Spannend ist aus theologischer Sicht ein damit indirekt verknüpfter Aspekt: Brand bezeichnete Roboter in einem Interview mit dem Deutschlandfunk als «Teil der Schöpfung:

„Sie kommen zwar nicht unmittelbar von Gott, aber sie sind trotzdem Teil der Schöpfung.“

Insofern ist KI nicht nur ein Thema für die Ethik, sondern auch für die Schöpfungslehre. Und hier stellen sich vor allem Fragen zum Menschen:

Was macht den Menschen aus?

Was ist der «Hauch Gottes», der ihn zum Leben erweckt? Und was bleibt, wenn beim moralischen Turing-Test nicht mehr zwischen Mensch und Maschine zu unterscheiden ist?

Haben Roboter ein Gewissen? Eine Seele?

Auch Aristoteles hat die Frage nach der Seele umgetrieben. Es wäre spannend zu wissen, wie der Begründer der Tugendethik künstliche Intelligenz analysieren und beurteilen würde. Er, der sogar Planeten als Lebewesen einstufte, würde bestimmt auch intelligente Maschinen für Lebewesen halten: Sie sind u.a. wahrnehmungs- und bewegungsfähig.

«Die Seele ist die erste Verwirklichung von etwas, was der Möglichkeit nach Leben hat.»

(Aristoteles, de anima)

Aristoteles würde KI auch ein bestimmtes «Seelenvermögen» nicht absprechen, etwas, was uns nach unserem heutigen Empfinden von «Seele» fremd scheint.

Ob Seele oder nicht – KI sind uns ein Gegenüber. Heute schon. Insofern ist es höchste Zeit für «künstliche Tugend».

Beitragsbild: Franck V. on Unsplash